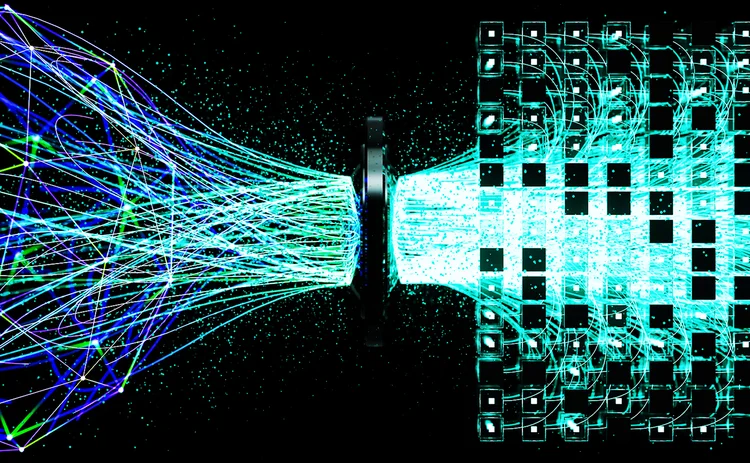

GenAIガバナンスにおけるモデル検証の再考

米国のモデルリスク責任者が、銀行が既存の監督基準を再調整する方法についてご説明いたします。

20年以上にわたり、モデルリスク管理(MRM)はシンプルでありながら強力な前提に基づいて構築されてきました。すなわち、定義された入力値を与えれば、モデルは安定した再現性のある出力を生成するというものです。バリュー・アット・リスク(VaR)エンジンの検証であれ、予想信用損失モデルの検証であれ、検証担当者はバックテスト、感度分析、そして想定される数学的真値とのベンチマークに依存してきました。

これらの手法は出力の安定性を前提としています。しかし、大手銀行におけるフロントオフィス業務やオペレーショナルワークフローでの大規模言語モデル(LLM)の活用拡大は、この前提に直接的な疑問を投げかけています。同一のプロンプトがモデル実行ごとに大きく異なる応答を生む場合、再現性のある出力という中核的な前提はもはや成り立ちません。その結果、生成型人工知能(GenAI)における検証失敗は、従来の統計的弱点ではなく

コンテンツを印刷またはコピーできるのは、有料の購読契約を結んでいるユーザー、または法人購読契約の一員であるユーザーのみです。

これらのオプションやその他の購読特典を利用するには、info@risk.net にお問い合わせいただくか、こちらの購読オプションをご覧ください: http://subscriptions.risk.net/subscribe

現在、このコンテンツを印刷することはできません。詳しくはinfo@risk.netまでお問い合わせください。

現在、このコンテンツをコピーすることはできません。詳しくはinfo@risk.netまでお問い合わせください。

Copyright インフォプロ・デジタル・リミテッド.無断複写・転載を禁じます。

当社の利用規約、https://www.infopro-digital.com/terms-and-conditions/subscriptions/(ポイント2.4)に記載されているように、印刷は1部のみです。

追加の権利を購入したい場合は、info@risk.netまで電子メールでご連絡ください。

Copyright インフォプロ・デジタル・リミテッド.無断複写・転載を禁じます。

このコンテンツは、当社の記事ツールを使用して共有することができます。当社の利用規約、https://www.infopro-digital.com/terms-and-conditions/subscriptions/(第2.4項)に概説されているように、認定ユーザーは、個人的な使用のために資料のコピーを1部のみ作成することができます。また、2.5項の制限にも従わなければなりません。

追加権利の購入をご希望の場合は、info@risk.netまで電子メールでご連絡ください。

詳細はこちら コメント

イタリアのスプレッド問題は(常に)信用問題というわけではない

イタリアの通貨同盟における役割に対する時折の疑念が、政治リスクプレミアムを増すと、経済学者は主張しています。

市場は決して忘れない:平方根則の持続的な影響

ジャン=フィリップ・ブショー氏はトレードの流れは資産価格に大きく、かつ長期的な影響があると主張する。

ポッドキャスト:ピエトロ・ロッシ氏による信用格付けとボラティリティ・モデルについて

確率論的手法とキャリブレーション速度の向上により、クレジットおよび株式分野における確立されたモデルが改善されます。

オペリスクデータ:カイザー社、病気の偽装により5億ドルの支払いを主導

また:融資不正取引が韓国系銀行を直撃;サクソバンクとサンタンデール銀行でAMLが機能せず。ORXニュースのデータより

大げさな宣伝を超えて、トークン化は基盤構造を改善することができる

デジタル専門家によれば、ブロックチェーン技術は流動性の低い資産に対して、より効率的で低コストな運用手段を提供します。

マルキールのサル:運用者の能力を測る、より優れたベンチマーク

iM Global Partnersのリュック・デュモンティエ氏とジョアン・セルファティ氏は、ある有名な実験が、株式選定者のパフォーマンスを評価する別の方法を示唆していると述べています。

IMAの現状:大きな期待と現実の対峙

最新のトレーディングブック規制は内部モデル手法を改定しましたが、大半の銀行は適用除外を選択しています。二人のリスク専門家がその理由を探ります。

地政学的リスクがどのようにシステム的なストレステストへと変化したのか

資源をめぐる争いは、時折発生するリスクプレミアムを超えた形で市場を再構築しています。